Pengantar

Kemajuan pesat kecerdasan buatan (Artificial Intelligence/AI) tidak lepas dari peran infrastruktur komputasi berskala besar. Model AI modern—seperti large language model, computer vision, dan sistem rekomendasi—membutuhkan daya komputasi yang jauh melampaui kemampuan satu server biasa.

Di sinilah GPU clusters memainkan peran penting. Arsitektur ini menjadi tulang punggung superkomputer dan data center yang digunakan untuk melatih model AI dengan miliaran parameter. Artikel ini membahas apa itu GPU cluster, bagaimana arsitekturnya bekerja, dan mengapa teknologi ini krusial bagi perkembangan AI saat ini.

Apa Itu GPU Cluster?

Kumpulan GPU yang Bekerja sebagai Satu Sistem

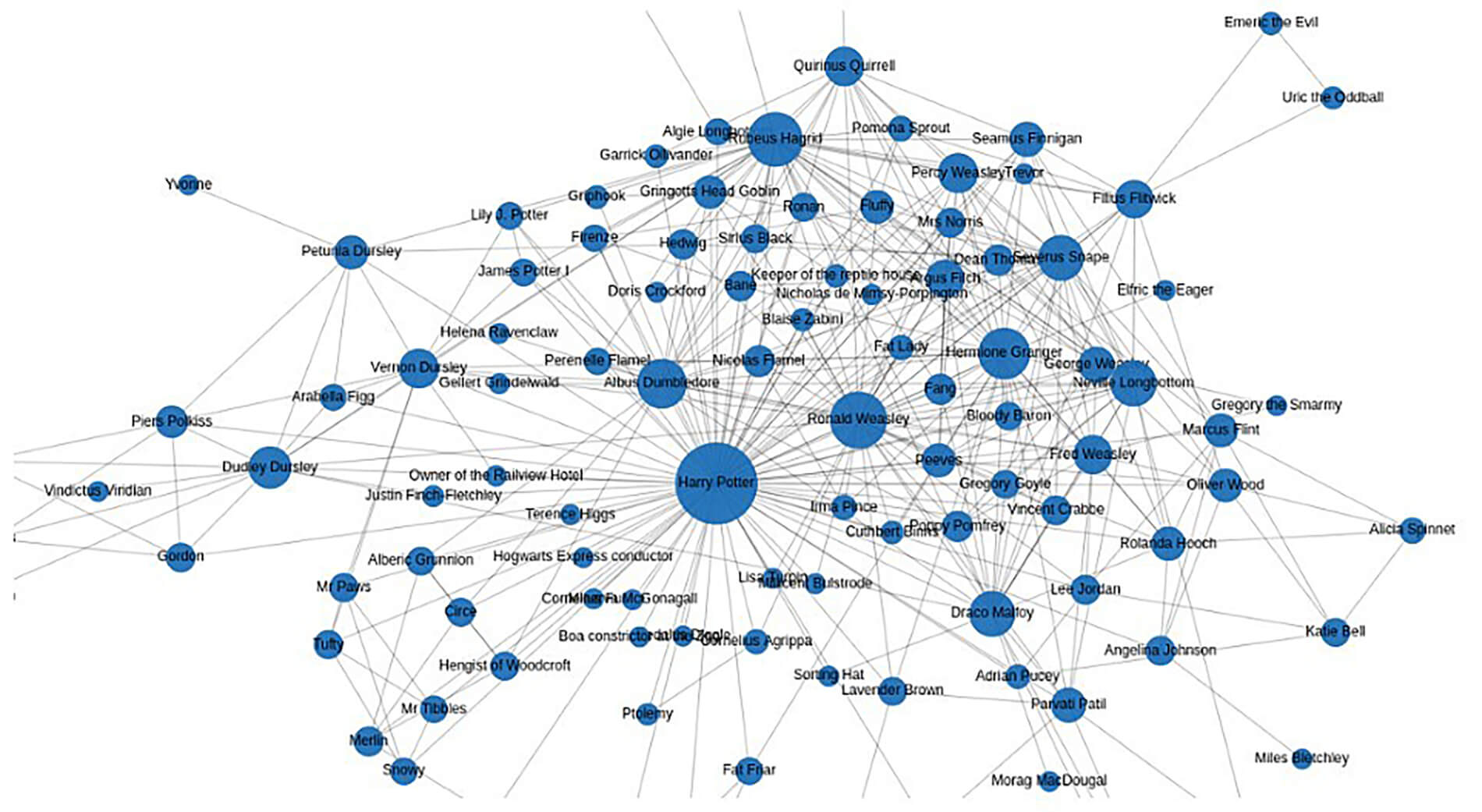

GPU cluster adalah sekumpulan server yang masing-masing dilengkapi dengan GPU (Graphics Processing Unit), kemudian dihubungkan melalui jaringan berkecepatan tinggi untuk bekerja secara paralel.

Berbeda dengan CPU yang dirancang untuk tugas umum, GPU memiliki ribuan core kecil yang sangat efisien untuk:

-

komputasi paralel

-

pemrosesan matriks

-

operasi numerik intensif

Karakteristik inilah yang membuat GPU sangat cocok untuk pelatihan model AI.

baca juga : Ransomware: Taktik “Triple Extortion” yang Tidak Hanya Mengunci Data, Tapi Juga Memeras Klien

Mengapa AI Membutuhkan GPU Cluster?

Skala Data dan Kompleksitas Model

Model AI modern dilatih menggunakan:

-

dataset berukuran sangat besar

-

arsitektur neural network yang kompleks

-

iterasi pelatihan berulang

Tanpa GPU cluster, proses pelatihan dapat memakan waktu berbulan-bulan. NVIDIA menjelaskan bahwa GPU acceleration memungkinkan pelatihan AI dilakukan dalam hitungan hari atau bahkan jam.

Arsitektur Dasar GPU Cluster

Bagaimana Komponen Utama Terhubung

Arsitektur GPU cluster umumnya terdiri dari beberapa komponen inti:

1. Node Komputasi

Setiap node biasanya berisi:

-

satu atau dua CPU

-

beberapa GPU (4–8 GPU per node)

-

RAM besar

-

storage lokal berkecepatan tinggi

Node ini menjalankan proses pelatihan secara paralel.

2. Interkoneksi Berkecepatan Tinggi

Menghindari Bottleneck Data

GPU cluster membutuhkan jaringan khusus seperti:

-

InfiniBand

-

NVLink

-

Ethernet berkecepatan tinggi

Interkoneksi ini memastikan pertukaran data antar GPU berlangsung cepat dan sinkron.

3. Storage Terdistribusi

Akses Data Tanpa Hambatan

Dataset AI yang besar disimpan pada sistem storage terdistribusi agar dapat diakses oleh seluruh node secara bersamaan tanpa menimbulkan latensi tinggi.

Bagaimana GPU Cluster Melatih Model AI

Prinsip Parallel dan Distributed Training

Pelatihan model AI pada GPU cluster umumnya menggunakan dua pendekatan:

Data Parallelism

Dataset dibagi ke beberapa GPU. Setiap GPU melatih model dengan subset data yang berbeda, lalu hasilnya digabungkan.

Model Parallelism

Model AI yang sangat besar dibagi ke beberapa GPU, sehingga satu GPU tidak harus memuat seluruh model.

Pendekatan ini memungkinkan pelatihan model berskala besar yang tidak mungkin dijalankan pada satu mesin saja.

GPU Cluster dan Superkomputer AI

Fondasi Sistem AI Skala Global

Banyak superkomputer tercepat di dunia menggunakan GPU cluster sebagai komponen utama. Daftar TOP500 menunjukkan bahwa mayoritas superkomputer modern mengandalkan GPU untuk workload AI dan HPC (High Performance Computing) (dikutip dari TOP500).

baca juga : Database Encryption: Mengapa Enkripsi Saja Tidak Cukup Tanpa Manajemen Kunci yang Ketat

Teknologi ini digunakan untuk:

-

riset ilmiah

-

pengembangan AI generatif

-

simulasi iklim

-

analisis genom

Tantangan dalam Implementasi GPU Cluster

Tidak Sekadar Menambah GPU

Beberapa tantangan utama meliputi:

-

konsumsi daya tinggi

-

manajemen panas

-

biaya infrastruktur

-

kompleksitas software dan orkestrasi

Tanpa desain arsitektur yang tepat, GPU cluster justru dapat menjadi tidak efisien.

baca juga : AI-Driven Phishing: Bagaimana Peretas Menembus Email Perusahaan

Kesimpulan

GPU cluster adalah fondasi utama di balik superkomputer dan sistem AI modern. Dengan arsitektur paralel, interkoneksi cepat, dan distribusi beban kerja yang efisien, GPU cluster memungkinkan pelatihan model AI dalam skala yang sebelumnya tidak terbayangkan.

Seiring meningkatnya kompleksitas AI, peran GPU cluster akan semakin krusial dalam mendorong inovasi teknologi di berbagai sektor.